Sobre Inteligencia Artificial Responsable y Gestión de Riesgos – Fundamentos e Impactos en las Administraciones Tributarias.

Introducción

La utilización de técnicas de Inteligencia Artificial (IA) crece en la sociedad, aplicada en los más distintos campos de actividad, con potencial de transformar la colectividad y la vida de las personas. El reciente lanzamiento del producto ChatGPT y la expectativa por el todavía más poderoso GPT-4 [1] lograron involucrar distintos segmentos de la sociedad, con más de 100 millones de cuentas activas hasta enero, publicación de miles de artículos y aumento impresionante de actividades en foros de discusiones sobre el tema. En esta gran participación sobresalieron discusiones, antes reservadas a grupos de especialistas y científicos sociales, sobre el rol de los humanos en la sociedad del futuro y los riesgos asociados al uso de estas tecnologías. Al final, la utilización cada vez más ampliada de IA impacta individuos, grupos, organizaciones, comunidades, sociedad, el medio ambiente y el planeta. Asociados a estos impactos están los riesgos, que pueden presentarse bajo varias formas.

Las administraciones tributarias, insertadas en estos ambientes, rápidamente identificaron aplicaciones de IA importantes para promocionar mejoras, algunas posiblemente disruptivas, en sus distintos segmentos de actuación, tales como atención a los contribuyentes, auditorías, cobranza, etc., partiendo para evaluar y probar estos usos.

Como toda nueva tecnología, las técnicas de IA no poseerán un avance uniforme. La empresa de consultoría Gartner propuso un modelo para evaluar el nacimiento y propagación de tecnologías, denominado “Hype Cycle for Emerging Technologies” [2], por el cual la tendencia de uso de una nueva tecnología puede pasar por 5 fases durante su ciclo de adopción: (1) Disparador de innovación, cuando una tecnología surge y las expectativas de su aplicabilidad comienzan a crecer; (2) Pico de las expectativas infladas, cuando las expectativas de aplicabilidad alcanzan su apogeo; (3) Valle de la desilusión, cuando muchas expectativas de uso decepcionan; (4) Pendiente de la iluminación, cuando las expectativas más bien fundadas son identificadas y trabajadas; (5) Meseta de la productividad, cuando las expectativas se transforman en productos de uso solidificado. La Figura a continuación presenta el Hype Cycle para IA referida al año 2022, con el comportamiento de varias tecnologías potencialmente aplicables a las administraciones tributarias. Para detalles, véase [3].

Fuente: Gartner Group

IA Responsable

El National Institute of Standards and Technology – NIST, de los Estados Unidos, indica que “los sistemas de IA son inherentemente de naturaleza sociotécnica, lo que significa que están influenciados por la dinámica social y el comportamiento humano. Los riesgos y beneficios de la IA pueden surgir de la interacción de aspectos técnicos combinados con factores sociales relacionados con la forma en que se usa un sistema, sus interacciones con otros sistemas de IA, quién lo opera y el contexto social en el que se implementa”. Además, menciona que “sin los controles adecuados, los sistemas de IA pueden amplificar, perpetuar o exacerbar los resultados no equitativos o no deseados para las personas y las comunidades. Con los controles adecuados, los sistemas de IA pueden mitigar y gestionar los resultados no equitativos”.

Estos impactos aparecen de modo más visible para las administraciones tributarias, que son gobernadas por los principios fundamentales del derecho tributario [4]. Por lo tanto, el uso de la IA también debe observar reglas o códigos de conduta adecuados al cumplimiento de estos principios, además de tratar los riesgos asociados.

En este contexto general, viene el concepto de “IA Responsable” («Responsible AI”), definido como la práctica de diseñar, desarrollar e implementar sistemas de IA con la buena intención de empoderar a los empleados y a las empresas, e impactar de manera justa a los clientes y a la sociedad, lo que permite a las instituciones generar confianza y escalar la IA con consistencia [5].

Para responder a todos estos requisitos, debe establecerse una gestión adecuada del ciclo de vida de los sistemas de IA, especialmente la gestión de los riesgos.

El gobierno de los Estados Unidos, el ISO/IEC y la OECD [6], de modo más visible, vienen trabajando sobre estos temas urgentes, de modo a proveer un marco para que empresas y gobierno puedan desarrollar sistemas de IA de bajo riesgo.

Estas primeras orientaciones ciertamente proveerán las bases para marcos similares de ámbito institucionales y de gobiernos. De esta forma, las administraciones tributarias también tendrán un escenario inicial establecido para organizar sus estructuras internas para mitigar estos riesgos y generar sistemas de IA confiables y adecuados.

El primer Marco formalizado proviene del NIST [1] y será presentado a continuación.

El Marco de Gestión de Riesgos para Inteligencia Artificial (AI RMF) [7]

Este Marco, desarrollado por el NIST con patrocinio del gobierno norteamericano [8], pretende ser de aplicación universal a todas tecnologías de IA, en todos los sectores. Fue publicado en enero de 2023 en conjunto con otros documentos correlatos, como por ejemplo un playbook animado que organiza y orienta gráficamente los componentes del Marco y su implementación.

La primera parte del documento trata de los conceptos e informaciones fundamentales que les sirven de base. La segunda parte describe el núcleo del Marco en sus cuatro componentes. La tercera parte contiene anexos que detallan los conceptos y funciones utilizados.

El Marco trata del uso de tecnologías equitativas y responsables, con responsabilidad social y sostenibilidad. Además, fue diseñado – de acuerdo con sus postulantes – para equipar a organizaciones e individuos, denominados actores de IA, con enfoques que aumentan la confiabilidad de los sistemas y ayudan a fomentar el diseño, desarrollo, implementación y uso responsable de los sistemas de IA a lo largo del tiempo.

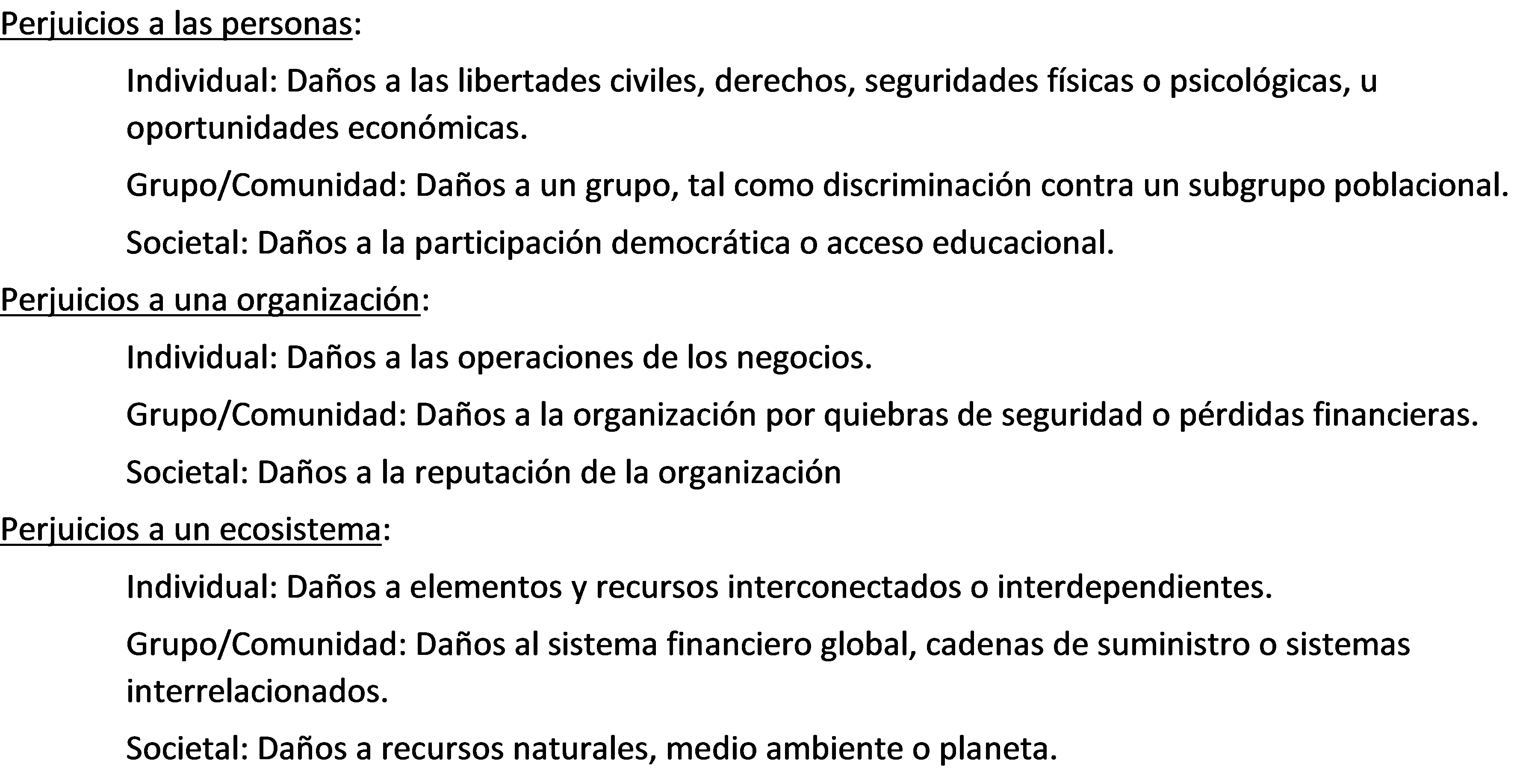

Los perjuicios potenciales asociados a los sistemas de IA fueron identificados con base en los siguientes ejemplos:

El Marco propone ser flexible, adaptable y ampliar las prácticas de riesgo alineadas a las leyes, regulaciones y normas, además de articular características de un sistema de IA digno de confianza y plantear direccionamiento para abordarlas. Estas características resaltarían en un sistema que sea: válido y confiable; seguro; protegido y resistente; responsable y transparente; explicable e interpretable; con privacidad mejorada; y con sesgos perjudiciales controlados (¡ambicioso!)

Algunas organizaciones, como las administraciones tributarias, tienen definiciones y guías establecidas para tolerancia a riesgos, que pueden ser ampliadas para cubrir los nuevos desafíos propuestos por el uso de IA.

A partir de estas definiciones, el AI RMF puede ser usado para gestionar los riesgos y documentar los procesos de gestión de riesgos.

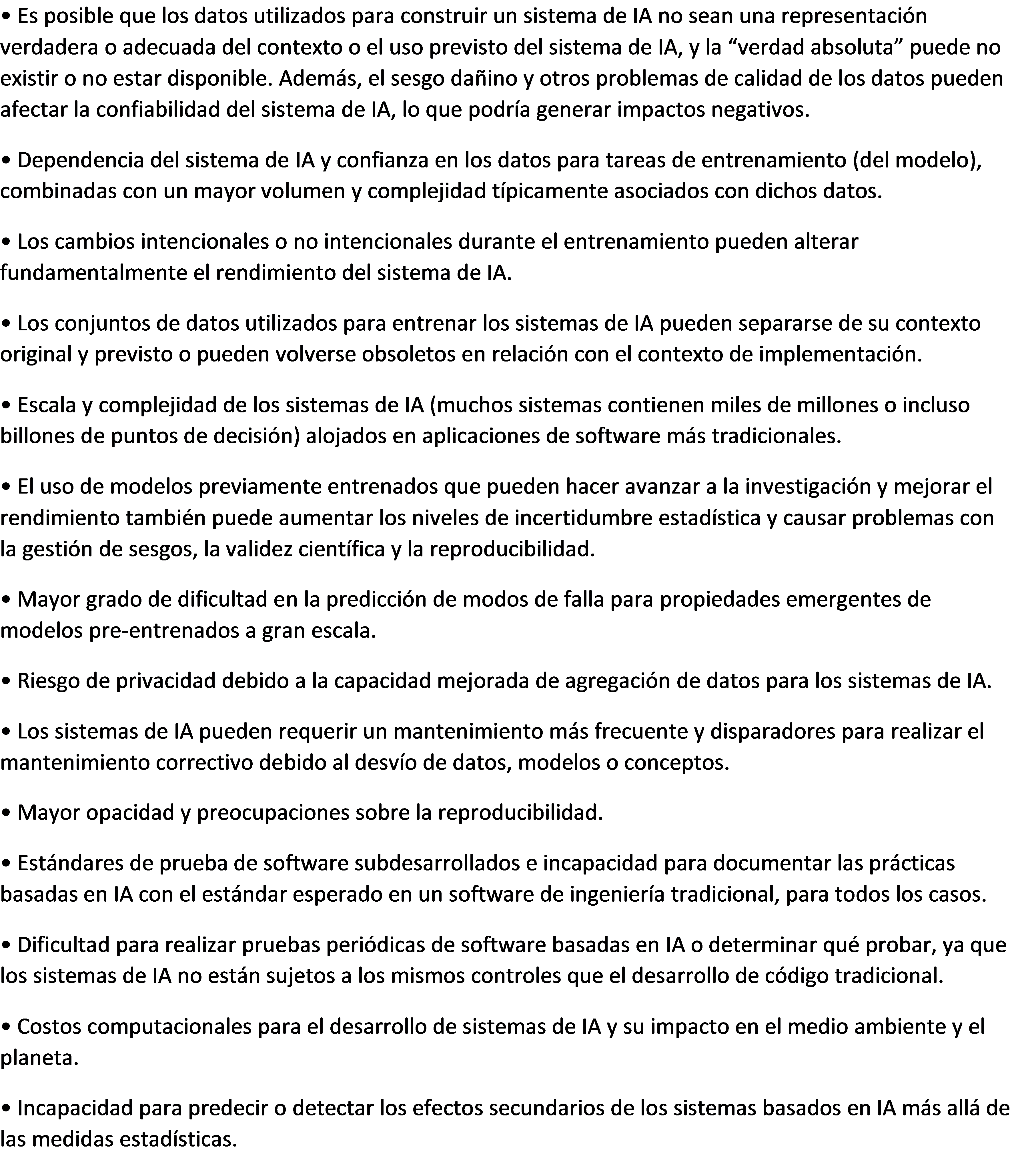

¿En qué se diferencian los riesgos de la IA de los riesgos del software tradicional?

Un aspecto importante de los riesgos asociados al uso de sistemas de IA es la aparición de nuevos riesgos y la exacerbación de los antiguos, con relación a los riesgos del software tradicional, que se resume a continuación con base en el Appendix B del AI RMF:

Composición del AI RMF

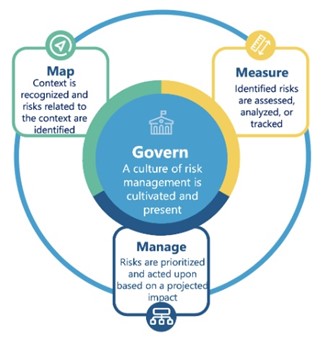

El núcleo del AI RMF está organizado en cuatro funciones, conforme la Figura a continuación, subdivididas en categorías y subcategorías.

Fuente: AI RMF Playbook

Gobernar (Govern):

Es una función transversal, que está difundida por toda la gestión de riesgo y habilita las otras funciones del proceso. Aspectos de la gobernación, tales como las relacionadas con la conformidad o evaluación, deben estar integradas a las demás funciones.

Mapear (Map):

La función MAP establece el contexto para enmarcar los riesgos relacionados con un sistema de IA. Abarca el establecimiento del contexto (objetivos, expectativas, actores, tolerancia a riesgos, etc.), categorización del sistema (métodos usados, modelos, limites, como sistema será utilizado, integridad científica, TEVV [Test, Evaluation, Validation & Verification], etc.), capacidades y otros (beneficios, uso, objetivos, costos, escopo, tecnología, riesgos legales, etc.).

Mensurar (Measure):

Emplea herramientas, técnicas y metodologías cuantitativas, cualitativas o de métodos mixtos para analizar, evaluar, comparar y monitorear el riesgo de IA y los impactos relacionados.

Gestionar (Manage):

La función Gestionar implica la asignación de recursos a los riesgos mapeados y medidos de forma periódica y según lo definido por la función Gobernar. El tratamiento de riesgos comprende planes para responder, recuperarse y comunicar sobre incidentes o eventos.

¿Cómo aplicar el AI RMF?

El NIST proporciona una versión preliminar del Manual de uso interactivo para implementación del Marco AI RMF (AI RMF Playbook), basado en las mejores prácticas y tendencias investigadas. Abarca las cuatro funciones definidas.

Esta versión preliminar es sencilla, pero puede ordenar las acciones y prioridades en la implementación del Marco.

Está disponible en https://pages.nist.gov/AIRMF/

La propuesta de la OECD

La OECD publicó en febrero pasado el informe “Avances en la rendición de cuentas en la IA: gobierno y gestión de riesgos a lo largo del ciclo de vida de una IA confiable” [9]. El concepto de “IA confiable” exige que los actores del sistema de IA sean responsables del funcionamiento adecuado de sus sistemas, de acuerdo con su función, contexto y capacidad de actuar.

Este informe presenta investigaciones y hallazgos sobre responsabilidades y los riesgos en los sistemas de IA, proporcionando una descripción general de cómo los marcos de gestión de riesgos y el ciclo de vida del sistema de IA pueden integrarse para promover una IA confiable. Explora procesos y atributos técnicos e identifica herramientas y mecanismos para definir, evaluar, tratar y controlar los riesgos en cada etapa del ciclo de vida del sistema de IA.

Como se observa, son propósitos muy cercanos a los indicados por el Marco AI RMF del NIST. Tal coincidencia era de esperarse, dado que estas dos instituciones (y otras más) cooperan en grupos de trabajo en la materia y tienen objetivos alineados, utilizando también la conceptualización propuesta en la norma general ISO 31000.

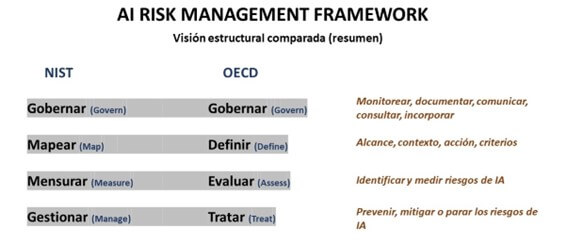

La Figura a continuación presenta un esquema comparativo de cómo se estructuran los modelos AI RMF de NIST y OECD. El contenido descriptivo de los niveles no es exactamente el mismo, pero los propósitos están alineados.

Además, pretende publicar en 2023 un catálogo de herramientas para orientar la construcción de un sistema de IA confiable, con una colección interactiva de recursos para el desarrollo e implementación de sistemas de IA que respeten los derechos humanos y sean justos transparentes, explicables, robustos y seguros.

Comentarios finales

Los sistemas de IA presentan desafíos distintos y más amplios que los sistemas de información tradicionales. Muchas aplicaciones exitosas ya fueron desarrolladas, pero el potencial evaluado es enorme, todavía inexplorado e inexplotado, así como los riesgos asociados. Se observa en el Hype Cycle de Gartner que las tecnologías identificadas de IA están, sin embargo, ubicadas mayormente en las fases “disparo de la innovación” y “pico de las expectativas infladas”. Todavía se llevarán a cabo muchas investigaciones, pruebas y desarrollos sobre posibles casos de uso. Éxitos y fracasos sucederán. Pero todo indica que los sistemas de IA estarán cada vez más presentes en nuestras vidas y, especialmente, en las administraciones tributarias.

Los conceptos y las prácticas de gestión de riesgos no son ajenos a las administraciones tributarias. Así, como usuarias estratégicas de estas tecnologías, que avanzan rápidamente, es importante para las administraciones tributarias mantenerse conectadas con las iniciativas en curso de gestión del ciclo de vida de los sistemas de IA, en especial la gestión de riesgos, para organizarse y adaptarse desde el inicio con las mejores y más convenientes prácticas.

*-*-*-*-*-*-*-*-*-*-*-*-*-*-

[1] Disponible en: https://openai.com/blog/chatgpt y https://www.technologyreview.com/2023/03/14/1069823/gpt-4-is-bigger-and-better-chatgpt-openai/

[2]Disponible en: https://www.techtarget.com/whatis/definition/Gartner-hype-cycle#

[3] Disponible en: https://www.gartner.com/en/articles/what-s-new-in-artificial-intelligence-from-the-2022-gartner-hype-cycle#

[4] Ejemplo de principios fundamentales del derecho tributario: obligatoriedad, destino del gasto público, proporcionalidad, equidad, legalidad, generalidad (véase ejemplo en https://blogs.ugto.mx/contador/clase-digital-4principios-fundamentales-del-derecho-tributario/)

[5] Disponible en: https://www.accenture.com/dk-en/services/applied-intelligence/ai-ethics-governance

[6] NIST (National Institute of Standards and Technology, Departamento de Comercio del Gobierno de los Estados Unidos); ISO/IEC (International Organization for Standardization / International Electrotechnical Commission); OECD (Organisation for Economic Co-operation and Development)

[7] AI RMF – Artificial Intelligence Risk Management Framework, en inglés. Disponible en: https://doi.org/10.6028/NIST.AI.100-1

[8] Disponible en: https://nvlpubs.nist.gov/nistpubs/ai/NIST.AI.100-1.pdf

[9] Disponible en: https://read.oecd.org/10.1787/2448f04b-en?format=pdf

17,358 total views, 11 views today

4 comentarios

El NIST ha publicado en la Web un centro de recursos para IA confiable y responsable (Trustworthy and Responsible AI Resource Center), que actúa como repositorio de publicaciones del gobierno federal sobre el tema. Está muy bueno. Disponible en https://airc.nist.gov/

«¡Excelente artículo sobre inteligencia artificial responsable y gestión de riesgos en las administraciones tributarias! Es impresionante ver cómo la implementación responsable de la IA puede ser una herramienta poderosa para optimizar y fortalecer la recaudación fiscal. La gestión de riesgos se vuelve cada vez más crucial en estos tiempos cambiantes, y las administraciones tributarias deben estar a la vanguardia de la innovación. Además, me complace compartir una gran plataforma que podría ser de gran ayuda en este proceso: https://gptnederlands.nl/. ¡Gracias por compartir este contenido valioso! Saludos cordiales, Alan Waker.» https://gptnederlands.nl/

¡Excelente artículo sobre inteligencia artificial responsable y gestión de riesgos en las administraciones tributarias! Es fundamental conocer los fundamentos y impactos de estas tecnologías en el ámbito fiscal. ¡Felicidades por el contenido de calidad!

Very well presented. Every quote was awesome and thanks for sharing the content. Keep sharing and keep motivating others.