Revisando la inteligencia artificial explicable (XAI) y su importancia en la administración tributaria

Introducción

Hace dos años, publicamos un post en este blog del CIAT destacando la creciente importancia de la XAI para el desarrollo de aplicaciones de Inteligencia Artificial (IA) en algunas áreas de la sociedad, especialmente en las administraciones tributarias [Seco, 2021]. La propuesta de este post es actualizar en la generalidad lo sucedido en algunos temas relacionados a la XAI y proveer referencias para estudios de mayor profundidad por parte de los interesados.

La IA explicable o XAI trata del desarrollo de técnicas / modelos que hacen comprensible el funcionamiento de un sistema de IA para una determinada audiencia.

Normalmente, los modelos de “caja negra” (black box), como las redes neuronales, el modelado difuso (fuzzy logic) y el aumento de gradiente (gradient boosting) proporcionan flexibilidad y una mayor precisión predictiva al tiempo que sacrifican la interpretabilidad. Los modelos de “caja blanca” (white box) tienen métodos más simples, como regresión lineal y árboles de decisión; sin embargo, suelen tener un poder predictivo más débil [Loyola-González, 2019]. Adicionalmente, Myrianthous (2023) indica que modelos más flexibles no garantizan mejores resultados, eso en función del fenómeno llamado overfitting: cuando, por acompañaren demasiadamente de cerca los ruidos y los errores de datos de entrenamiento, ya no logran generalizar apropiadamente puntos de datos nuevos, desapercebidos.

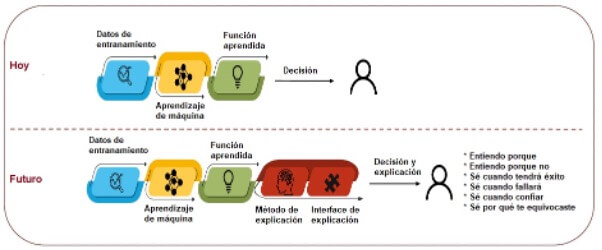

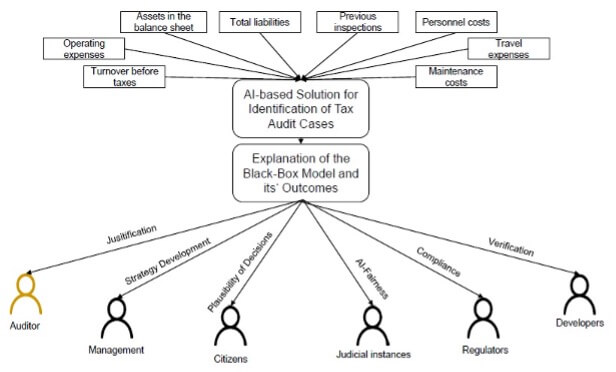

La Figura 1 muestra la “explicación” ubicada en el flujo de implementación de soluciones de IA:

Figura 1: Fuente – [Fettke, 2023]

Hasta el momento, los términos interpretabilidad y explicabilidad son usualmente tratados como sinónimos en el campo de la IA. Trabajos recientes proponen significados distintos: interpretabilidad definiría que los modelos de IA sean inteligibles por su naturaleza, como por ejemplos árboles de decisión (al seguir caminos en el árbol, el usuario acompaña fácilmente una fórmula matemática); explicabilidad correspondería a un modelo de IA del tipo caja negra que fuera comprendido utilizando recursos externos, como las visualizaciones [Kuzniacki, 2021].

Relevancia

Kuzniacki y Tylinski (2020) muestran que la mayor fuente de riesgos para integración de IA al proceso legal en Europa son las Regulaciones Generales de Protección de Datos-RGPD[1] y la Convención Europea de Derechos Humanos-CEDH[2]. Los artículos legales mencionados por los autores son los siguientes:

El derecho a una explicación (artículos 12, 14 y 15 de la RGPD): este derecho trata de la transparencia de un modelo de IA. Si las autoridades tributarias toman una decisión basada en un modelo de IA, deben poder explicar a los contribuyentes cómo se tomó esta decisión, proporcionando información suficientemente completa para que los mismos puedan actuar para impugnar la decisión, corregir inexactitudes o solicitar su cancelación.

El derecho a la intervención humana (artículo 22 de la RGPD): El derecho a la intervención humana es una herramienta legal para impugnar decisiones que se basan en datos procesados a través de medios automáticos, como los modelos de IA. La idea es que los contribuyentes deben tener derecho a impugnar una decisión automatizada del modelo de IA y hacer que la revise una persona (generalmente un auditor fiscal). Para que esto sea efectivo, el contribuyente debe primero saber cómo el modelo llegó a la conclusión (regresando entonces al derecho a una explicación).

El derecho a un juicio justo (artículo 6 de la CEDH): este derecho abarca las garantías mínimas de igualdad de medios y el derecho a la defensa. Significa que se debe permitir a los contribuyentes revisar efectivamente la información en la que las autoridades tributarias basan sus decisiones. Estos deben disponer de los medios para comprender integralmente los factores legales relevantes utilizados para decidir sobre una aplicación de la ley tributaria y la lógica detrás del modelo de IA que impulsó a las autoridades a tomar una determinada decisión.

La prohibición de discriminación y la protección de la propiedad (CEDH): La prohibición de la discriminación junto con la protección de la propiedad determina que las autoridades tributarias dicten decisiones de manera no discriminatoria, es decir, que no traten a los contribuyentes de manera diferente sin una justificación objetiva y razonable. Este requisito busca enfrentar la tendencia que tienen determinados algoritmos de IA a sobrellevar sesgos, como consecuencia del desequilibrio de los datos que se utilizaron para entrenarlos.

Considerando que la normativa europea sirve de base para que muchos países desarrollen sus propias legislaciones, estas observaciones son importantes para la discusión del tema.

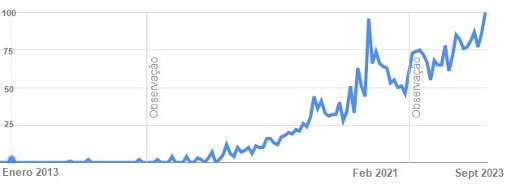

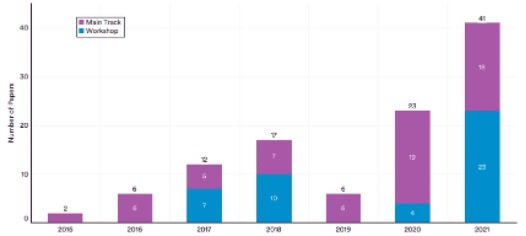

En nivel mundial, la creciente relevancia de la XAI puede ser observada por (a) la evolución del Índice de Popularidad de las Tendencias del Google[3] para el término “Explainable AI” en los últimos 10 años (Figura 2) y (b) la evolución de la cantidad de artículos sobre interpretabilidad y explicabilidad de IA presentados a la conceptuada Conferencia NEURIPS entre 2015 y 2021 (Figura 3):

Figura 2: Evolución de la búsqueda de “Explainable AI” en Google (fuente: Google Trends)

Figura 3: Evolución del número de artículos aceptados sobre interpretabilidad y explicabilidad en la Conferencia NEURIPS 2015-2021 – Fuente: [Ngo y Sakhaee, 2022]

Métodos de explicabilidad

Paralelamente con la IA, también prosperan los métodos que explican e interpretan modelos de aprendizaje de máquina.

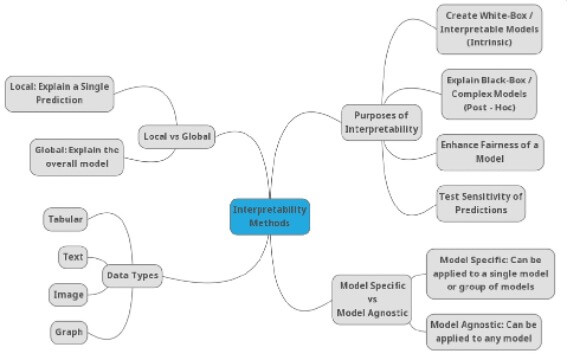

En Linardatos et al. (2021) se propone un mapa mental para la taxonomía de técnicas de interpretabilidad de aprendizaje de máquina, basado en los objetivos para los cuales estos métodos fueron creados y las formas a través de las cuales logran este propósito (Figura 4).

Figura 4: Mapa mental de la taxonomía de técnicas de interpretabilidad para aprendizaje de máquina (Fuente: Linardatos et al., 2021)

En esta taxonomía, se pueden dividir los métodos de interpretabilidad en función de los tipos de algoritmos aplicables: si su aplicación sólo se restringe a una familia específica de algoritmos, entonces estos métodos se denominan específicos del modelo; por el contrario, los métodos que podrían aplicarse a todos los algoritmos posibles se denominan agnósticos (independientes del modelo).

Además, se introducen 4 categorías de métodos de interpretabilidad basadas en el objetivo para el que fueron creados y las formas como logran este propósito: métodos para explicar modelos complejos de caja negra; métodos para crear modelos de caja blanca; métodos que promueven la equidad y restringen la existencia de discriminación; y métodos para analizar la sensibilidad de las predicciones de los modelos.

XAI y auditorías tributarias

Se considera que la XAI no es un concepto monolítico y la adopción de un modelo único para la administración pública no es razonable.

Según Mehdiyev, et al. (2021), la suficiencia y relevancia de las explicaciones están determinadas por las propiedades del entorno de toma de decisiones, incluidas las características del usuario, los objetivos de los mecanismos de explicación, la naturaleza de los procesos subyacentes, la credibilidad y la calidad de las predicciones generadas por los sistemas de IA adoptados.

Por lo tanto, para desarrollar soluciones que generen explicaciones relevantes para los procesos de la administración pública, es importante identificar y describir los elementos de estos diversos factores y examinar sus interdependencias.

La referencia anterior propone un modelo conceptual describiendo los principales elementos para una solución de XAI en un caso de uso de auditoría tributaria, que puede ser adaptada para otros usos en la administración pública.

En este modelo las partes interesadas serían: auditores, gestores, ciudadanos, instancias judiciales, autoridades reguladoras y desarrolladores de IA. Estas podrían ser adicionalmente clasificadas con otros factores más detallados, tales como pericia en IA y experiencia con el tema. Estos usuarios requieren explicaciones con distintos objetivos, tales como: verificación de un rastro de razonamiento en los métodos de IA adoptados; justificación/ratificación de la confiabilidad en los resultados del sistema generado; depuración de los modelos de IA subyacentes para mejorar la precisión y la eficiencia computacional; aprender del sistema, especialmente en ausencia de conocimiento del dominio; mejorar la efectividad o eficiencia para tomar buenas decisiones rápidamente, etc.

Después de evaluar las características de los procesos de las partes interesadas, interdependencias y aspectos relacionados con la toma de decisiones, el estudio referenciado identificó varios escenarios para un caso de uso en auditoría tributaria, el cual demandaría soluciones distintas de XAI. La Figura 5 resume estos escenarios.

Figura 5: Escenarios de XAI para auditoría tributaria (fuente: Mehdiyev, N., et al., 2021)

Los varios escenarios propuestos son ejemplos de la multiplicidad de soluciones explicativas que pueden existir en un único caso de uso (en este caso, auditoría tributaria), destacándose la diversidad del público que requiere explicación, su motivación/necesidades y otros requisitos.

Es importante resaltar que los niveles de explicabilidad de IA están divididos en globales, que explican el modelo en general y sus reglas genéricas de funcionamiento; y locales, que explican para cada dato cómo razonó el modelo y las reglas que llevaron a un determinado resultado.

Las técnicas de explicabilidad son muchas y se eligen conforme la necesidad y/o factibilidad de uso. Algunos ejemplos: SHAP (SHapley Additive exPlanations), LIME (Local Interpretable Model-agnostic Explanation), Permutation Importance, Partial Dependence Plot, etc. Dallanoce (2022) describe las principales técnicas disponibles, en un nivel adecuado para no-expertos.

Algoritmos de IA en la administración tributaria: ¿siempre es necesaria la explicabilidad?

La aplicación de la explicabilidad de algoritmos de IA está vinculada especialmente a las relaciones entre gobiernos y ciudadanos (G2C) y gobiernos y empresas (G2B).

Esto se debe a que proveer explicaciones a este nivel es obligatorio, mientras que para las decisiones en el ámbito privado sólo es obligatorio cuando la ley así lo exige. En ambos casos, abogados y científicos de datos deben trabajar en conjunto [Kuzniacki, 2021].

Cuando la explicabilidad es necesaria, Kuzniacki (2021) recomienda que, al modelar IA con base en la legislación tributaria, se debe mantener informado a los expertos humanos en la materia, no confiando totalmente en los modelos, para para mitigar riesgos advenidos de la falta o deficiencia de explicabilidad.

Comentarios finales

Aunque la importancia del tema sea reconocida, el enfoque que deben adoptar las administraciones tributarias con respecto al uso de XAI sigue siendo una cuestión en abierto, motivando investigaciones académicas e institucionales. Asimismo, en evento realizado en la Universidad de Amsterdam[4], Dr. Peter Fettke propuso cuatro directrices para la comprehensión y diseño de XAI para sistemas tributarios:

Directriz 1: Desarrollar un modelo tributario

Directriz 2: Comunicar explicaciones

Directriz 3: Generar y evaluar explicaciones

Directriz 4: Desarrollar y evaluar un modelo de aprendizaje de máquina

Los métodos de XAI pueden contribuir para desarrollar la responsabilidad, la equidad, la transparencia y evitar el sesgo discriminatorio en la administración pública, además de proporcionar mejor aceptación y confianza en los sistemas de IA.

Investigaciones em el área de XAI también podrían integrarse a los trabajos del Centro de Analítica Avanzada del CIAT[5], considerando el contexto del América Latina y el Caribe, de modo a generar orientaciones a las administraciones tributarias de la región.

Así, la XAI es más un tema por considerar en el universo de la digitalización de las administraciones tributarias y la buena gobernanza fiscal.

Bibliografía

Dallanoce, F. 2022. “Explainable AI: A Comprehensive Review of the Main Methods”. Medium January 4. Disponible en: https://medium.com/mlearning-ai/explainable-ai-a-complete-summary-of-the-main-methods-a28f9ab132f7

Fettke, P. 2023. “Explainable Artificial Intelligence (XAI) Supporting Public Administration Processes. On the Potential of XAI in Tax Audit”. Conferencia en la Universidad de Amsterdam / Amsterdam Centre for Tax Law. Marzo.

Kuzniacki, B. 2021. “Explainability in Artificial Intelligence & (Tax) Law”. International Law and Global South. June, 3. Disponible en: https://internationallawandtheglobalsouth.com/guest-post-explainability-in-ai-and-international-law-with-specific-reference-to-tax-law/

Kuzniacki, B., Tylinski, K. 2020. “Legal Risks Stemming from the Integration of Artificial Intelligence (AI) to Taxlaw”. Kluer International tax blog. Disponible en: kluwertaxblog.com/2020/09/04/legal-risks-stemming-from-the-integration-of-artificial-intelligence-ai-to-tax-law/

Linardatos, P., Papastefanopoulos, V., Kotsiantis, S. 2021. “Explainable AI: A Review of Machine Learning Interpretability Methods”. Entropy 23, 18. https://dx.doi.org/10.3390/e23010018

Loyola-González, O. 2019. «Black-Box vs. White-Box: Understanding Their Advantages and Weaknesses From a Practical Point of View» in IEEE Access, vol. 7, pp. 154096-154113, 2019, https://doi.org/10.1109/ACCESS.2019.2949286

Mehdiyev, N., Houy, C., Gutermuth, O., Mayer, L., Fettke, P. 2021. “Explainable Artificial Intelligence (XAI) Supporting Public Administration Processes – On the Potential of XAI in Tax Audit Processes”. In: Ahlemann, F., Schütte, R., Stieglitz, S. (eds) Innovation Through Information Systems. WI 2021. Lecture Notes in Information Systems and Organisation, vol 46. Springer, Cham. https://doi.org/10.1007/978-3-030-86790-4_28

Myrianthous, G. 2023. “Understanding The Accuracy-Interpretability Trade-Off”. Towards Data Science. Oct, 6. Disponible en: https://towardsdatascience.com/accuracy-interpretability-trade-off-8d055ed2e445

Ngo, H., Sakhaee, E. 2022. “AI Index Report 2022: Chapter 3 – Technical AI Ethics”. Stanford University

Seco, A. 2021. “Inteligencia Artificial Explicable (XAI) y su Importancia en la Administración Tributaria”. Blog del CIAT 01 noviembre. Véase: https://www.ciat.org/inteligencia-artificial-explicable-xai-y-su-importancia-en-la-administracion-tributaria/

[1] Véase https://gdpr-info.eu/

[2] Véase https://www.echr.coe.int/Documents/Convention_ENG.pdf

[3] Google Trends Popularity Index

[4] Conference: “Towards eXplainable Artificial Intelligence (XAI) in Taxation: The Future of Good Tax Governance”, Amsterdam Centre for Tax Law, Marzo 2023

[5] Véase: https://www.ciat.org/ciat-y-microsoft-colaboran-en-la-transformacion-y-modernizacion-de-las-administraciones-tributarias-de-america-latina/

10,462 total views, 7 views today